Gli schiavi di ChatGpt

Dietro alle performance sempre più sorprendenti dei sistemi di intelligenza artificiale c’è la manodopera sfruttata di una nuova categoria di lavoratori di serie B in tutto il mondo. Che dovrebbero uscire dall’ombra ed essere tutelati

Computer che sanno chiacchierare con le persone, rispondere a quesiti su praticamente ogni campo dello scibile umano, ma anche comporre testi creativi, come finti reportage con lo stile di famosi giornalisti o commedie brillanti. Le più recenti applicazioni dell’intelligenza artificiale (Artificial Intelligence, AI) promettono di portare una rivoluzione nelle nostre vite quotidiane e sono già state salutate con entusiasmo dai guru della tecnologia così come da milioni di cittadini, evocando scenari futuristici e potenzialità quasi infinite. Dal suo rilascio, lo scorso novembre, ChatGpt aveva già raggiunto a gennaio i 100 milioni di utenti: un exploit che ne ha fatto l’app con la crescita più rapida di sempre. Tecnicamente, il prodotto lanciato dalla società della Silicon Valley OpenAI è un chatbot, ossia un software che simula le conversazioni umane consentendo agli utenti di interagire con i dispositivi digitali come se stessero comunicando con una persona reale. Eppure, senza chiamare in causa gli androidi assassini del cinema pop, i motivi per guardare con prudenza alle innovazioni legate all’intelligenza artificiale non mancano, e non si limitano ai dubbi etici legati al loro uso in svariati settori della vita sociale, a cominciare da quello del lavoro, con il rischio – su cui molti hanno già messo in guardia – di scalzare gli stessi esseri umani. In realtà, dietro alle sorprendenti (per quanto ancora imperfette) performance dei software dialoganti o delle piattaforme capaci di generare autonomamente immagini artistiche, ci sono lavoratori umanissimi che, negli angoli più remoti del pianeta, pagano in prima persona il prezzo di questa come di altre tecnologie, di cui a beneficiare sono essenzialmente i benestanti utilizzatori del mondo ricco. Una recente inchiesta di Time ha rivelato che OpenAI ha sfruttato, per perfezionare il suo prodotto, la manodopera dei dipendenti di una società kenyana, pagati con stipendi da fame per sottoporsi a ore di lavoro psicologicamente usurante. L’acronimo “Gpt”, infatti, sta per “Generative pretrained transformer”, letteralmente “Trasformatore preaddestrato generativo”: in pratica, queste “menti digitali”, per funzionare, devono appunto essere prima addestrate, e per la precisione nutrite di enormi quantità di testi reperiti a caso nella grande rete di internet, vasto deposito di linguaggio umano. Ma poiché molti di questi contenuti sono “tossici” – ovvero violenti, razzisti e pieni di pregiudizi – dai primi test è emerso come l’intelligenza artificiale assorbisse questa tossicità e la riproponesse poi nei colloqui con gli utenti. Come ovviare all’inconveniente? Siccome anche un team di centinaia di umani avrebbe impiegato decenni per esaminare e “ripulire” manualmente tutti i set di dati da dare in pasto ai software, era necessario costruire un ulteriore sistema di intelligenza artificiale in grado di rilevare un linguaggio tossico, per esempio l’incitamento all’odio, per poi rimuoverlo dalle piattaforme. In pratica, bisognava alimentare un’AI con esempi etichettati di violenza, pregiudizi, abusi sessuali, per insegnarle a riconoscerli da sola e, una volta integrata nel chatbot, a filtrare le risposte all’utente, rendendole eticamente più ortodosse. Così – ha rivelato Time – dal novembre 2021 OpenAI ha inviato decine di migliaia di frammenti di testo, che per i suoi contenuti raccapriccianti «sembravano usciti dai recessi più oscuri di internet», a una società di outsourcing in Kenya, dove alcune decine di etichettatori di dati leggevano e catalogavano centinaia di brani, su turni di nove ore, per un compenso compreso tra circa 1,32 e 2 dollari all’ora. Alcuni di loro hanno dichiarato di essere rimasti mentalmente segnati dalla mansione, con traumi e visioni ricorrenti legate ai contenuti esaminati. Mesi dopo, queste criticità avrebbero portato alla chiusura anticipata dei rapporti tra OpenAI e Sama, l’azienda appaltatrice, che ha sede in California ma impiega lavoratori anche in Uganda e India per clienti della Silicon Valley come Google, Meta e Microsoft. Nel frattempo, però, nel febbraio dell’anno scorso Sama aveva fatto partire un altro progetto pilota per OpenAI: raccogliere immagini sessuali e violente, alcune delle quali illegali per la legge statunitense, da etichettare e consegnare al committente. D’altra parte – ha dichiarato poi un portavoce di OpenAI – questo è «un passo necessario» per rendere più sicuri i suoi strumenti di intelligenza artificiale (tra cui figurano appunto quelli per la generazione di immagini). Alla fine, la natura traumatica del lavoro ha spinto Sama a cancellare tutti i suoi contratti con il colosso di San Francisco otto mesi prima del previsto. Ma la vicenda ha rappresentato un campanello d’allarme sul rovescio della medaglia di una tecnologia all’apparenza sinonimo di progresso per tutti e che invece, in alcune aree del mondo, va a braccetto con le più reiterate forme di sfruttamento. «Nonostante il ruolo fondamentale svolto da questi professionisti dell’arricchimento dei dati, un numero crescente di ricerche rivela le precarie condizioni di lavoro che essi devono affrontare», ha ammesso la Partnership on AI, rete di organizzazioni che operano nel settore. A Nairobi, dove un altro recente scandalo ha rivelato il caso dei locali moderatori di contenuti per Facebook, pagati un dollaro e mezzo all’ora per visualizzare scene di esecuzioni, stupri e abusi, l’analista politica Nanjala Nyabola è stata ancora più diretta: «Dovrebbe essere ormai chiaro che il nostro attuale paradigma di digitalizzazione ha un problema di lavoro – ha dichiarato -. Stiamo passando dall’ideale di un internet costruito attorno a comunità di interessi condivisi, a uno dominato dalle prerogative commerciali di una manciata di aziende situate in specifiche aree geografiche». Per Nyabola, autrice tra l’altro del libro “Digital Democracy, Analogue Politics” (Zed Books), «una massa critica di manodopera sottopagata viene reclutata nelle condizioni legalmente più deboli per sostenere l’illusione di un internet migliore. Ma questo modello lascia miliardi di persone vulnerabili a una miriade di forme di sfruttamento sociale ed economico, il cui impatto non comprendiamo ancora appieno». Una studiosa che queste dinamiche le ha, invece, ben chiare già da un po’ è Timnit Gebru, ingegnera informatica che nel dicembre 2020 è stata al centro di un caso per la sua improvvisa uscita da Google a Mountain View, dove lavorava come co-responsabile del gruppo di studio sull’etica dell’intelligenza artificiale. Gebru, che due anni prima aveva anche collaborato a uno storico studio sui pregiudizi razziali e di genere nel software di riconoscimento facciale, aveva infatti stilato un documento che evidenziava rischi e pregiudizi nei modelli linguistici di grandi dimensioni. Di fronte al suo rifiuto di ritirare il testo prima della pubblicazione, Google la licenziò in tronco. Oggi, la tenace scienziata 39enne ha deciso di provare a cambiare il settore nel suo nuovo ruolo di fondatrice del Dair, Distributed Artificial Intelligence Research Institute, che opera con ricercatori esperti di AI in tutto il mondo. «Le mansioni di etichettatura dei dati vengono spesso svolte lontano dal quartier generale della Silicon Valley: dal Venezuela, dove i lavoratori visionano immagini per migliorare l’efficienza dei veicoli a guida autonoma, alla Bulgaria, dove i rifugiati siriani alimentano i sistemi di riconoscimento facciale con i selfie classificati in base a razza, sesso e categorie di età. Questi compiti sono spesso affidati a lavoratori precari in Paesi come l’India, il Kenya, le Filippine o il Messico», rivela Gebru in un recente saggio scritto per la rivista Noema insieme ad Adrienne Williams e Milagros Miceli, che ha operato a stretto contatto con gli annotatori di dati in Siria, Bulgaria e Argentina. «Le aziende tecnologiche – denunciano le tre ricercatrici – si assicurano di assumere soggetti provenienti da comunità povere e svantaggiate, come rifugiati, carcerati e altre persone con poche opzioni di lavoro, spesso assumendole tramite aziende terze». Per cambiare rotta è necessario finanziare la ricerca sull’AI «sia come causa sia come prodotto di condizioni di lavoro ingiuste». I guru della tecnologia, ma anche i media, hanno oggi la responsabilità di mettere in luce il lavoro sfruttato dietro l’illusione di macchine sempre più simili agli esseri umani. Perché «queste macchine sono costruite da eserciti di lavoratori sottopagati in tutto il mondo». Che hanno il diritto di essere tutelati.Articoli correlati

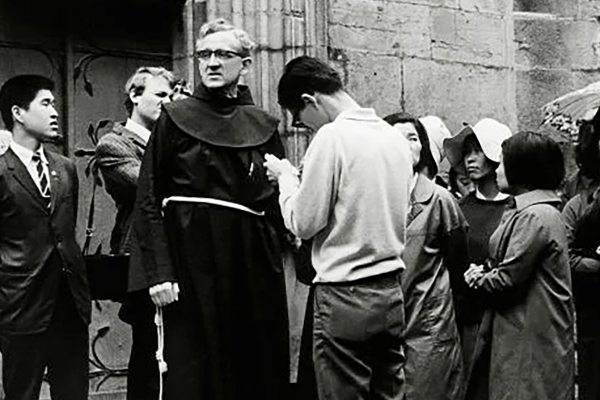

Da soldato SS a missionario

L’incredibile storia di padre Gereon che, arruolato dai nazisti, si rifiuta di giurare fedeltà a Hitler e diventa…

Maroua: disabili al Centro

Nella cittadina di Maroua, in Camerun, il Centro Shalom, promosso dal Pime, accompagna bambini e ragazzi in percorsi di…

«Kla»: La gratitudine che dà gioia

Tra la gente della mia comunità di Ouassadougou, in Costa d’Avorio, la gratitudine è alla base della gioia, ne è…